Handbuch: Viel Lärm um nichts

Obwohl sich unsere heutigen Buchstabenformen aus römischen epigraphischen Buchstaben entwickelt haben, sind unsere Ziffern arabischen Ursprungs. Das römische Nummerierungssystem basierte auf Großbuchstaben. Wir wissen, dass sich diese Buchstaben gut für monumentale Inschriften eignen, aber wenn sie als Ziffern verwendet werden, werden sie schnell zu langen Zeichenketten, die schwer zu lesen und für jede Art von mathematischen Berechnungen praktisch unmöglich sind.

Die fehlende Figur

Das antike Griechenland und Rom mögen die Zentren des Lernens für Geschichte und Literatur gewesen sein, aber das Zentrum für mathematische Studien lag woanders. Frühe Kulturen suchten nach einem Nummerierungssystem, das in einer Vielzahl von Situationen funktionieren würde, aber jahrhundertelang wurde ihre Suche durch das Fehlen des Konzepts der Null behindert. Die Idee der Null als Zahl wurde erst um das vierte Jahrhundert herum verwirklicht - und das geschah nicht in Rom. Die Null war schon viel früher ein fester Bestandteil des Maya-Zahlensystems, hatte aber keinen Einfluss auf die Zahlensysteme der Alten Welt.

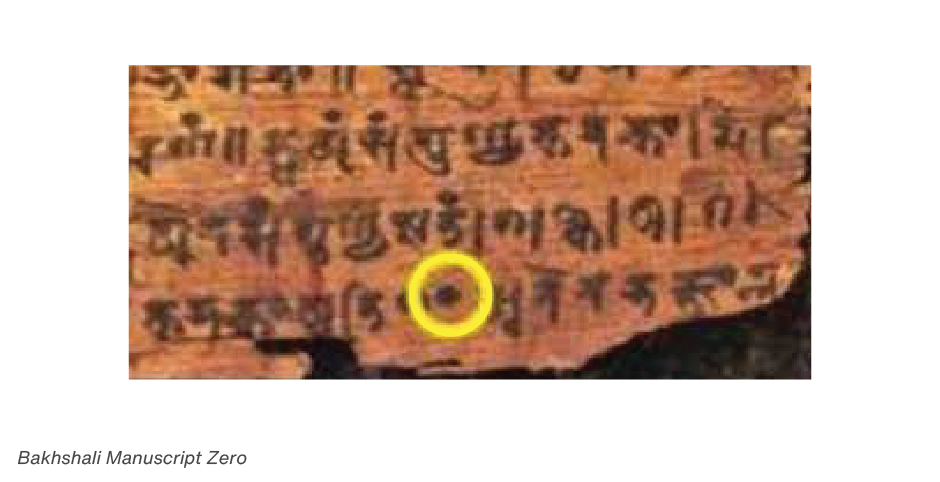

Dieser Einfluss ist Indien zu verdanken. Im Bakhshali-Manuskript, einem alten Handbuch zur Arithmetik für Kaufleute, wird durchgängig ein großer Punkt verwendet, der wahrscheinlich der Vorläufer des heute noch gebräuchlichen Hohlzeichens ist. Das Manuskript enthält die früheste bekannte indische Verwendung eines Null-Symbols. Es wurde in einer Form des literarischen Sanskrit geschrieben.

Infolge ihres Kontakts mit Indien übernahmen die Händler des Nahen Ostens auch das Konzept der Null und wurden selbst zu hoch entwickelten Mathematikern. Die Symbole, die sie zur Darstellung von Zahlen verwendeten, ähnelten größtenteils denen, die wir heute verwenden. Es dauerte jedoch viele Jahre, bis die westliche Welt diese Zeichen in Druck und Schrift übernahm. Der Handel führte schließlich zur Umstellung von römischen auf arabische Ziffern. Die Händler fanden die römischen Ziffern zu schwierig zu handhaben und zu anfällig für Fehler. Mit der Ausbreitung des Handels verbreitete sich auch die Verwendung der arabischen Ziffern.

Erste typografische Ziffern

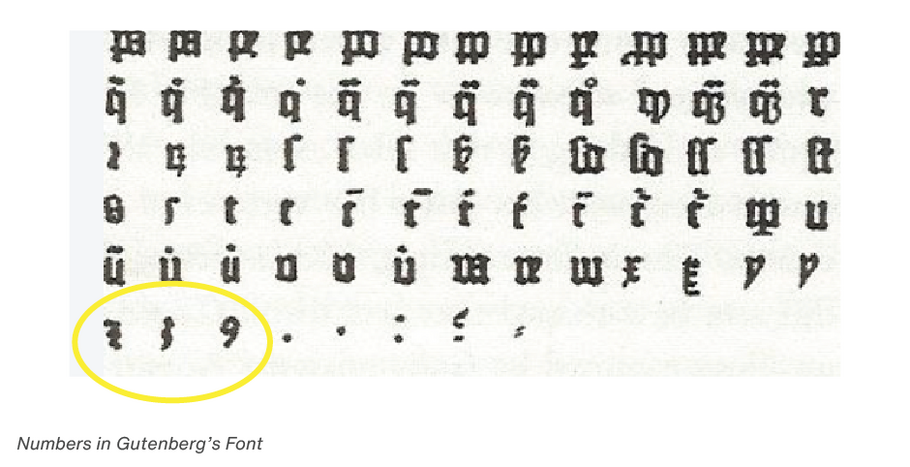

Als Gutenberg die Buchdruckerkunst erfand, nahm er eine Reihe von Ziffern in seine Schrift auf. Fast 100 Jahre lang wurden die Ziffern jedoch als "pi"-Zeichen behandelt und nicht als Teil eines bestimmten Schriftentwurfs erstellt.

Erste schriftsensiblen Ziffern

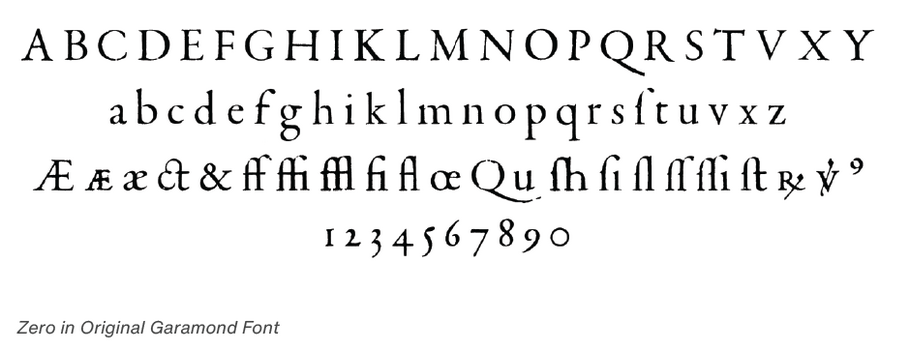

Claude Garamond, dem großen Schriftgestalter des 16. Jahrhunderts, wird allgemein die Schaffung der ersten Schrift zugeschrieben, die Ziffern enthielt, die speziell zur Ergänzung der Buchstabenformen einer bestimmten Schrift entwickelt wurden. Abgesehen von stilistischen Variationen waren die Ziffern von Garamond über 200 Jahre lang der Standard.

Garamond wollte seine Ziffern in den Text einfügen und entwarf sie in denselben Proportionen wie die Kleinbuchstaben. Wie die Kleinbuchstaben basieren auch die Ziffern von Garamond auf drei Formen: aufsteigend, mittel und absteigend. Die Null wurde nicht hervorgehoben, um Verwechslungen mit dem Kleinbuchstaben o zu vermeiden.

Dieser Kleinbuchstabenstil blieb bis zum Ende des 18. Jahrhunderts ein Vorbild für Schriftgestalter.

In der heutigen Welt der Computer spielt die Null eine sehr wichtige Rolle. Auf Mikroebene bestehen Computer aus Schaltkreisen, die entweder ein- oder ausgeschaltet werden. Der eingeschaltete Zustand wird durch eine 1 und der ausgeschaltete Zustand durch eine 0 dargestellt. Der Programmiercode, der zur Steuerung von Computern geschrieben wird, besteht, wenn man ihn auf seine einfachste Form reduziert, aus 1en und 0en. Es ist schwer vorstellbar, wie Computer ohne das Konzept der Null und die Ziffer, die wir zu ihrer Darstellung verwenden, hätten entwickelt werden können.